- PROBABILITÉS (CALCUL DES)

- PROBABILITÉS (CALCUL DES)Le calcul des probabilités est certainement l’une des branches les plus récentes des mathématiques, bien qu’il ait en fait trois siècles et demi d’existence. Après s’être cantonné dans l’étude des jeux de hasard, il s’est introduit dans presque toutes les branches de l’activité scientifique, aussi bien dans l’analyse (théorie du potentiel), l’économie, la génétique (lois de Mendel), la physique corpusculaire (toutes les théories statistiques) que dans la psychologie et l’informatique, dont la source est l’étude de la quantité d’information, donnée probabiliste s’il en est. Il est rare de trouver un tel exemple de «recouvrement» dans le domaine scientifique. On peut, sans paradoxe, soutenir que toutes les mathématiques anciennes sont un cas particulier du calcul des probabilités, le certain étant de l’aléatoire dont la réalisation a une probabilité égale à 1.Le calcul des probabilités est né de l’étude des jeux de hasard. Ce dernier mot, transmis par l’Espagne, vient d’Arabie. L’arabe az-zahr , «dé à jouer», s’est transformé en azar , «hasard» (et souvent «revers») en espagnol. La base philologique, si l’on peut dire, du calcul des probabilités est donc le jeu (pile ou face, jeu de roulette, cartes). Pascal et le chevalier de Méré sont certainement les premiers à avoir voulu introduire le quantitatif dans ces études et à les mathématiser. On essaye aujourd’hui de réduire l’importance de ce point de départ en cherchant un fondement axiomatique et en enseignant le calcul des probabilités sans parler de hasard (à peine ose-t-on parler d’aléa). Il n’en est pas moins vrai que, sans l’activité des joueurs, le calcul des probabilités n’aurait sûrement pas vu le jour. Depuis le XVIIe siècle, de nombreux mathématiciens ont apporté une très importante contribution au développement de cette science: parmi les plus marquants, citons Laplace, dont le tome VII des Œuvres complètes est consacré au calcul des probabilités, et Denis Poisson, Carl Friedrich Gauss, Henri Poincaré, Émile Borel, Maurice Fréchet, Paul Levy, A. N. Kolmogorov et A. Khintchine.1. Position concrète du problèmePrenons les deux cas suivants qui concernent la réalisation d’un événement inconnu:a ) naissance d’un garçon, dans le cas de la première naissance enregistrée à l’état civil du cinquième arrondissement de Paris dans l’année 1972,b ) obtention de face dans le jet d’une pièce parfaitement symétrique.Attacher une «probabilité» à ces deux événements pose un certain nombre de questions sur lesquelles Borel s’est penché: dans le premier cas, la probabilité résulte de la connaissance détaillée et précise d’un grand nombre de phénomènes analogues; selon le langage de Borel, c’est une probabilité statistique. Dans le second exemple, la symétrie parfaite de la pièce donne autant de chances aux deux faces; on dira donc qu’il y a une chance sur deux d’obtenir face, c’est-à-dire que la probabilité de l’événement est 0,5. «Toute probabilité concrète, écrit Borel, est en définitive une probabilité statistique définie seulement avec une certaine approximation. Bien entendu, il est loisible aux mathématiciens, pour la commodité de leurs raisonnements et de leurs calculs, d’introduire des probabilités rigoureusement égales à des nombres simples, bien définis: c’est la condition même de l’application des mathématiques à toute question concrète; on remplace les données réelles, toujours inexactement connues, par des valeurs approchées sur lesquelles on calcule comme si elles étaient exactes: le résultat est approché, de même que les données» (Borel, Le Hasard ).Reprenons l’exemple de la pièce de monnaie qui permet de définir la plus simple des variables aléatoires . On a ainsi l’ensemble des valeurs prises par la variable, soitpile, face, et, la pièce étant parfaitement symétrique, la probabilité de chacune de ces valeurs est 1/2. Si l’on remplace la pièce par un dé, lui aussi parfaitement symétrique, l’égale probabilité de chacune des faces entraîne que la variable aléatoire attachée au dé aurait comme ensemble de valeursface 1, face 2, face 3, face 4, face 5, face 6, chacune des valeurs étant prise avec la probabilité 1/6. De cette façon, on a introduit l’ensemble 行 des épreuves (ou espace 行), ainsi que les probabilités attachées à chacune de ces épreuves, ces probabilités étant obtenues dans les cas expérimentaux que nous venons d’évoquer, soit par la connaissance du passé (taux de masculinité), soit par des considérations théoriques sur la nature du problème (ici, la symétrie).On peut introduire un plus grand degré de généralité en considérant que dé et pièce ne sont plus symétriques. On sera amené à donner une probabilité particulière (positive ou, à la limite, nulle) à chacune des deux faces de la pièce ou à chacune des faces du dé, la somme de ces probabilités étant égale à 1. On attribue 1 à la probabilité de l’événement certain: ici, que la pièce tombe sur pile ou sur face, que le dé tombe sur la face 1, ou la face 2, ou la face 3, ou la face 4, ou la face 5, ou la face 6. On peut supposer aussi que l’ensemble des épreuves est dénombrable; à l’épreuve d’indice i on associe la probabilité pi , avec pi 閭 0, et pi = 1. Franchissant encore une étape, on pourra supposer que l’ensemble des épreuves a la puissance du continu (par exemple Rn , ou l’espace des fonctions de carré sommable, ou l’espace des fonctions continues). Cela pose des problèmes, qui ont conduit au calcul des probabilités moderne et à l’axiomatique de Kolmogorov.2. AxiomatiqueJusqu’à présent, «probabiliser» un ensemble d’épreuves consistait à répartir, en chacun des éléments de cet ensemble, un ensemble de valeurs positives ou nulles et dont la somme était égale à 1. Ce problème ne soulevait aucune difficulté. Il n’en est pas de même quand l’espace des épreuves 行 a la puissance du continu et quand on veut associer une probabilité à chacun des sous-ensembles de 行: dans sa généralité, le problème est sans solution. On sera amené à isoler dans l’ensemble des sous-ensembles de 行 une 靖-algèbre ou tribu. Une tribu 龍 est une classe de parties de 行 possédant les propriétés suivantes:見) 龍 contient 行 et ø (ø est l’ensemble vide);廓) 龍 est stable pour les opérations de réunion, d’intersection et de passage au complémentaire, c’est-à-dire que, si les parties A et B appartiennent à une tribu, A 聆 B, A 惡 B et 璉A et 璉B (complémentaires de A et de B) en font aussi partie (cf. théorie élémentaire des ENSEMBLES);塚) 龍 est stable par rapport à la réunion dénombrable. On rapprochera cette définition de celle qui est donnée dans le chapitre 1 de l’article INTÉGRATION ET MESURE.Ces sous-ensembles s’appellent des événements . De ces axiomes on déduit que la tribu 龍 est stable par rapport aux opérations de passage à la borne supérieure, à la borne inférieure, aux limites supérieures et inférieures et aux limites dans le cas dénombrable. C’est sur cette classe 龍 de parties que l’on peut répartir une probabilité, c’est-à-dire appliquer la classe sur le segment fermé [0, 1], avec les conditions suivantes:1) la probabilité d’un événement certain est égale à 1, c’est-à-dire:

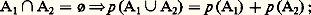

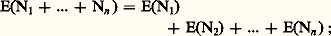

2) la probabilité est une fonction additive d’ensemble; si donc les événements A1 et A2 appartiennent à la tribu, on a:

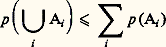

2) la probabilité est une fonction additive d’ensemble; si donc les événements A1 et A2 appartiennent à la tribu, on a: 3) l’application est 靖-additive en ce sens que, si An est une suite croissante An +1 念 An d’événements dont la réunion A appartient à la tribu, alors p (An ) tend vers p (A).La classe initiale sera complétée par les ensembles p -négligeables qui sont les ensembles contenus dans ceux de la tribu qui ont une probabilité nulle. 龍 complété ainsi sera encore désigné par 龍. Le triplet ( 行, 龍, p ) a reçu le nom d’espace de probabilité . On obtient deux résultats importants qui sont l’inégalité de Boole :

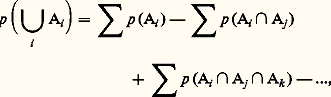

3) l’application est 靖-additive en ce sens que, si An est une suite croissante An +1 念 An d’événements dont la réunion A appartient à la tribu, alors p (An ) tend vers p (A).La classe initiale sera complétée par les ensembles p -négligeables qui sont les ensembles contenus dans ceux de la tribu qui ont une probabilité nulle. 龍 complété ainsi sera encore désigné par 龍. Le triplet ( 行, 龍, p ) a reçu le nom d’espace de probabilité . On obtient deux résultats importants qui sont l’inégalité de Boole : et l’égalité de Poincaré :

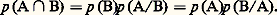

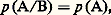

et l’égalité de Poincaré : dans laquelle les différents qui figurent portent sur toutes les combinaisons possibles des indices différant les uns des autres.La définition d’une probabilité sur un espace produit s’introduit de manière naturelle. Un autre élément axiomatique est la probabilité de l’événement A conditionné par l’événement B, notée p (A/B), que l’on appelle parfois l’axiome de Bayes : La probabilité du concours de deux événements A et B (appartenant naturellement à 龍), soit A 惡 B, est égale au produit de la probabilité de B par la probabilité de A si l’événement B a lieu (ce que nous avons appelé p (A/B)); ce qui se traduit par les égalités suivantes, dans lesquelles A et B jouent un rôle symétrique:

dans laquelle les différents qui figurent portent sur toutes les combinaisons possibles des indices différant les uns des autres.La définition d’une probabilité sur un espace produit s’introduit de manière naturelle. Un autre élément axiomatique est la probabilité de l’événement A conditionné par l’événement B, notée p (A/B), que l’on appelle parfois l’axiome de Bayes : La probabilité du concours de deux événements A et B (appartenant naturellement à 龍), soit A 惡 B, est égale au produit de la probabilité de B par la probabilité de A si l’événement B a lieu (ce que nous avons appelé p (A/B)); ce qui se traduit par les égalités suivantes, dans lesquelles A et B jouent un rôle symétrique: L’axiome de Bayes permet d’introduire la notion d’événements indépendants : A et B sont dits indépendants si:

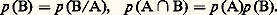

L’axiome de Bayes permet d’introduire la notion d’événements indépendants : A et B sont dits indépendants si: ce qui entraîne naturellement:

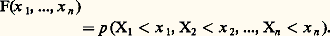

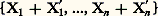

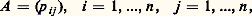

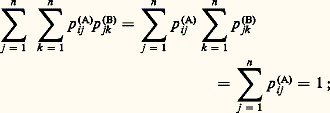

ce qui entraîne naturellement: Une variable aléatoire à valeurs dans 行, est une application mesurable d’un espace de probabilité ( 行, 龍, p ) dans un espace 行1 muni d’une tribu 龍1. Un cas particulier important est celui où le doublet ( 行1, 龍1) est l’espace Rn muni de la tribu borélienne (cf. INTÉGRATION ET MESURE, chap. 3).3. Instruments de travailLois de répartitionLa fin du chapitre précédent a attiré l’attention sur le cas où ( 行1, 龍1) est l’espace Rn muni de la tribu borélienne. Dans ce cas, l’ensemble (X1, ..., Xn ) des n coordonnées d’un point constitue la variable aléatoire et l’on peut introduire une fonction de n variables x 1, ..., xn :

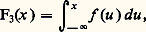

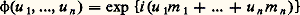

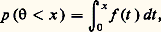

Une variable aléatoire à valeurs dans 行, est une application mesurable d’un espace de probabilité ( 行, 龍, p ) dans un espace 行1 muni d’une tribu 龍1. Un cas particulier important est celui où le doublet ( 行1, 龍1) est l’espace Rn muni de la tribu borélienne (cf. INTÉGRATION ET MESURE, chap. 3).3. Instruments de travailLois de répartitionLa fin du chapitre précédent a attiré l’attention sur le cas où ( 行1, 龍1) est l’espace Rn muni de la tribu borélienne. Dans ce cas, l’ensemble (X1, ..., Xn ) des n coordonnées d’un point constitue la variable aléatoire et l’on peut introduire une fonction de n variables x 1, ..., xn : On lui donne le nom de loi de probabilité (ou fonction de répartition) de la variable aléatoire considérée. C’est une fonction non décroissante de l’ensemble des n coordonnées. Dans le cas d’une coordonnée, la fonction F(x ) non décroissante se décompose, selon le résultat classique de Lebesgue, en une somme:

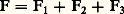

On lui donne le nom de loi de probabilité (ou fonction de répartition) de la variable aléatoire considérée. C’est une fonction non décroissante de l’ensemble des n coordonnées. Dans le cas d’une coordonnée, la fonction F(x ) non décroissante se décompose, selon le résultat classique de Lebesgue, en une somme: de trois fonctions non décroissantes, où 1 est la fonction des «sauts» (c’est-à-dire qu’elle est constante en dehors des points de discontinuité de F, dont l’ensemble est au plus dénombrable, et qu’elle a en ces points de discontinuité une variation, un «saut» égal à celui de F). La fonction F 漣 1, qui est donc continue, se décompose en une somme de deux fonctions non décroissantes; d’abord 3, absolument continue , c’est-à-dire égale à une intégrale de la forme suivante:

de trois fonctions non décroissantes, où 1 est la fonction des «sauts» (c’est-à-dire qu’elle est constante en dehors des points de discontinuité de F, dont l’ensemble est au plus dénombrable, et qu’elle a en ces points de discontinuité une variation, un «saut» égal à celui de F). La fonction F 漣 1, qui est donc continue, se décompose en une somme de deux fonctions non décroissantes; d’abord 3, absolument continue , c’est-à-dire égale à une intégrale de la forme suivante: puis 2, égale naturellement à F 漣 1 漣 3, qui sera non décroissante continue mais non absolument continue; on prendra 2 telle qu’elle ne soit susceptible de variation que sur un ensemble de mesure nulle. Un exemple classique de cette dernière situation est la fonction attachée à l’ensemble triadique de Cantor: le nombre x étant compris entre 0 et 1, on l’exprime dans le système de base 3, soit:

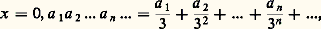

puis 2, égale naturellement à F 漣 1 漣 3, qui sera non décroissante continue mais non absolument continue; on prendra 2 telle qu’elle ne soit susceptible de variation que sur un ensemble de mesure nulle. Un exemple classique de cette dernière situation est la fonction attachée à l’ensemble triadique de Cantor: le nombre x étant compris entre 0 et 1, on l’exprime dans le système de base 3, soit: où ai est égal à 0, 1 ou 2. Considérons tous les x qui peuvent s’exprimer uniquement avec des ai égaux à 0 ou 2 (dans le cas où deux représentations sont possibles, on retiendra x si l’une des deux représentations ne comporte que des 0 ou des 2). Pour un tel x , posons:

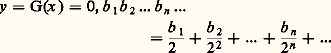

où ai est égal à 0, 1 ou 2. Considérons tous les x qui peuvent s’exprimer uniquement avec des ai égaux à 0 ou 2 (dans le cas où deux représentations sont possibles, on retiendra x si l’une des deux représentations ne comporte que des 0 ou des 2). Pour un tel x , posons: en base 2, avec bi = 0 si ai = 0 et bi = 1 si ai = 2; en dehors de l’ensemble des x considérés, la fonction G sera constante. Cette fonction est continue et ne peut pas être représentée par une intégrale, car elle n’est pas absolument continue.La décomposition F = 1 + 2 + 3 est unique; bien entendu, une ou deux des fonctions Fi peuvent être nulles.La définition:

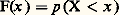

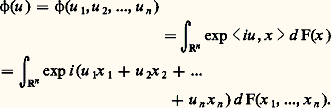

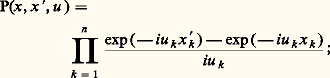

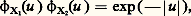

en base 2, avec bi = 0 si ai = 0 et bi = 1 si ai = 2; en dehors de l’ensemble des x considérés, la fonction G sera constante. Cette fonction est continue et ne peut pas être représentée par une intégrale, car elle n’est pas absolument continue.La décomposition F = 1 + 2 + 3 est unique; bien entendu, une ou deux des fonctions Fi peuvent être nulles.La définition: et les axiomes auxquels obéit p entraînent que F est continue à gauche, c’est-à-dire que F(x ) = F(x 漣 0). La donnée de la fonction de répartition permet de calculer la valeur de la probabilité de tous les ensembles probabilisables. C’est donc un instrument de travail essentiel.Fonction caractéristiqueParallèlement à la fonction de répartition, le calcul des probabilités utilise la fonction caractéristique, introduite par H. Poincaré, puis, sous sa forme actuelle, par P. Levy, donnée par l’intégrale de Lebesgue-Stieltjes:

et les axiomes auxquels obéit p entraînent que F est continue à gauche, c’est-à-dire que F(x ) = F(x 漣 0). La donnée de la fonction de répartition permet de calculer la valeur de la probabilité de tous les ensembles probabilisables. C’est donc un instrument de travail essentiel.Fonction caractéristiqueParallèlement à la fonction de répartition, le calcul des probabilités utilise la fonction caractéristique, introduite par H. Poincaré, puis, sous sa forme actuelle, par P. Levy, donnée par l’intégrale de Lebesgue-Stieltjes: Le passage de la fonction 﨏 à la fonction F se fait par l’intermédiaire de la formule d’inversion de Fourier. Si la fonction de répartition est continue sur la frontière du pavé:

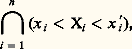

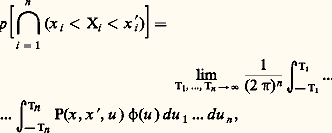

Le passage de la fonction 﨏 à la fonction F se fait par l’intermédiaire de la formule d’inversion de Fourier. Si la fonction de répartition est continue sur la frontière du pavé: on a:

on a: où:

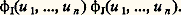

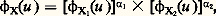

où: si la fonction de répartition n’était pas continue sur la frontière, cette égalité devrait subir les modifications habituelles de la théorie de la transformation de Fourier (cf. analyse HARMONIQUE).La fonction caractéristique possède plusieurs propriétés qui rendent son emploi fréquent en calcul des probabilités. La première propriété est topologique: Si une suite 1, 2, ..., Fn , ... de fonctions de répartition converge en tout point de Rn vers une fonction de répartition limite F, alors la suite 﨏1, ..., 﨏n , ... des fonctions converge, uniformément, dans tout domaine borné contenant l’origine, vers la fonction caractéristique 﨏 de F. Cet énoncé admet la réciproque suivante, souvent utilisée: Si en tout point de Rn la suite 﨏1, ..., 﨏n , ... converge vers une fonction caractéristique 﨏, alors 1, ..., Fn , ... converge vers une fonction de répartition F (sauf peut-être aux discontinuités éventuelles de F) dont 﨏 est la fonction caractéristique.La deuxième propriété, d’usage très courant également, est la suivante: Si un ensemble I =X1, ..., Xn et un ensemble J =X1 , ..., X n ont respectivement pour fonctions caractéristiques 﨏I(u 1, ..., un ) et 﨏J(u 1, ..., un ), les ensembles I et J étant indépendants , l’ensemble:

si la fonction de répartition n’était pas continue sur la frontière, cette égalité devrait subir les modifications habituelles de la théorie de la transformation de Fourier (cf. analyse HARMONIQUE).La fonction caractéristique possède plusieurs propriétés qui rendent son emploi fréquent en calcul des probabilités. La première propriété est topologique: Si une suite 1, 2, ..., Fn , ... de fonctions de répartition converge en tout point de Rn vers une fonction de répartition limite F, alors la suite 﨏1, ..., 﨏n , ... des fonctions converge, uniformément, dans tout domaine borné contenant l’origine, vers la fonction caractéristique 﨏 de F. Cet énoncé admet la réciproque suivante, souvent utilisée: Si en tout point de Rn la suite 﨏1, ..., 﨏n , ... converge vers une fonction caractéristique 﨏, alors 1, ..., Fn , ... converge vers une fonction de répartition F (sauf peut-être aux discontinuités éventuelles de F) dont 﨏 est la fonction caractéristique.La deuxième propriété, d’usage très courant également, est la suivante: Si un ensemble I =X1, ..., Xn et un ensemble J =X1 , ..., X n ont respectivement pour fonctions caractéristiques 﨏I(u 1, ..., un ) et 﨏J(u 1, ..., un ), les ensembles I et J étant indépendants , l’ensemble: a pour fonction caractéristique:

a pour fonction caractéristique: Il est donc facile d’obtenir la fonction caractéristique de la somme de deux variables aléatoires indépendantes si l’on connaît la fonction caractéristique de chacune d’elles. Avec les mêmes hypothèses, l’obtention de la fonction de répartition nécessite l’emploi du «produit de composition», ou «convolution» (cf. DISTRIBUTIONS [Mathématiques]). Si l’on pose:

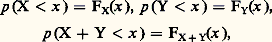

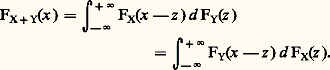

Il est donc facile d’obtenir la fonction caractéristique de la somme de deux variables aléatoires indépendantes si l’on connaît la fonction caractéristique de chacune d’elles. Avec les mêmes hypothèses, l’obtention de la fonction de répartition nécessite l’emploi du «produit de composition», ou «convolution» (cf. DISTRIBUTIONS [Mathématiques]). Si l’on pose: on a, pour X et Y indépendants,

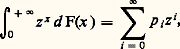

on a, pour X et Y indépendants, Si 行 est l’ensemble des entiers naturels N, on utilise souvent la fonction génératrice:

Si 行 est l’ensemble des entiers naturels N, on utilise souvent la fonction génératrice: pi étant la probabilité de la valeur i . La fonction génératrice de la somme de deux variables indépendantes est encore le produit des fonctions génératrices de chacune de ces variables.Autres outilsQuelle que soit la fonction de répartition, la fonction caractéristique (et, dans le cas particulier précédent, la fonction génératrice) d’une variable aléatoire existe. Il n’en est pas toujours de même pour des nombres, appelés les moments , attachés à la loi de répartition. Le moment d’ordre p , p entier positif, est l’intégrale:

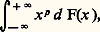

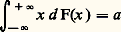

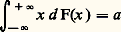

pi étant la probabilité de la valeur i . La fonction génératrice de la somme de deux variables indépendantes est encore le produit des fonctions génératrices de chacune de ces variables.Autres outilsQuelle que soit la fonction de répartition, la fonction caractéristique (et, dans le cas particulier précédent, la fonction génératrice) d’une variable aléatoire existe. Il n’en est pas toujours de même pour des nombres, appelés les moments , attachés à la loi de répartition. Le moment d’ordre p , p entier positif, est l’intégrale: que l’on note souvent E(Xp ), espérance mathématique de Xp . Avec cette notation, la fonction caractéristique est:

que l’on note souvent E(Xp ), espérance mathématique de Xp . Avec cette notation, la fonction caractéristique est: Dans tous les cas, on a:

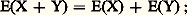

Dans tous les cas, on a: de plus, si X et Y sont indépendants, on a:

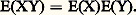

de plus, si X et Y sont indépendants, on a: Entre les moments et la fonction caractéristique, on a la relation suivante: S’il existe un moment d’ordre p , la fonction caractéristique admet à l’origine une dérivée d’ordre p égale à:

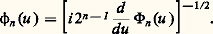

Entre les moments et la fonction caractéristique, on a la relation suivante: S’il existe un moment d’ordre p , la fonction caractéristique admet à l’origine une dérivée d’ordre p égale à: Enfin, on utilise parfois une fonction appelée fonction de concentration de Paul Levy. C’est la probabilité maximale contenue dans un intervalle fermé de longueur l , c’est-à-dire:

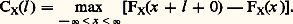

Enfin, on utilise parfois une fonction appelée fonction de concentration de Paul Levy. C’est la probabilité maximale contenue dans un intervalle fermé de longueur l , c’est-à-dire: On appelle variance de X, ou carré de l’écart type, la différence:

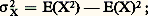

On appelle variance de X, ou carré de l’écart type, la différence: elle mesure également la dispersion de la variable aléatoire X. On appelle covariance des variables aléatoires X et Y la quantité:

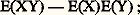

elle mesure également la dispersion de la variable aléatoire X. On appelle covariance des variables aléatoires X et Y la quantité: le quotient:

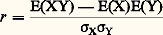

le quotient: qui, d’après l’inégalité de Schwarz, est compris entre 漣 1 et + 1, s’appelle le coefficient de corrélation de X et Y. Encore que ce fait soit contesté par Fréchet, ce coefficient donne une idée de la dépendance des deux variables X et Y. D’après ce qui a été dit, si X et Y sont indépendants, r est nul; mais r peut être nul sans qu’il y ait indépendance de X et Y, ce qui justifie l’objection de Fréchet.4. Lois et fonctions cractéristiques fondamentalesVariable certaineLa première loi que l’on rencontre est la loi d’un élément certain ou presque certain. Elle correspond au cas où 諸 捻 行, la probabilité p étant telle que p (face=F0019 諸) = 1. Il en résulte que la probabilité d’un événement quelconque ne contenant pas 諸 est égale à 0. Si 行 = Rn , la fonction caractéristique de cette variable aléatoire certaine est:

qui, d’après l’inégalité de Schwarz, est compris entre 漣 1 et + 1, s’appelle le coefficient de corrélation de X et Y. Encore que ce fait soit contesté par Fréchet, ce coefficient donne une idée de la dépendance des deux variables X et Y. D’après ce qui a été dit, si X et Y sont indépendants, r est nul; mais r peut être nul sans qu’il y ait indépendance de X et Y, ce qui justifie l’objection de Fréchet.4. Lois et fonctions cractéristiques fondamentalesVariable certaineLa première loi que l’on rencontre est la loi d’un élément certain ou presque certain. Elle correspond au cas où 諸 捻 行, la probabilité p étant telle que p (face=F0019 諸) = 1. Il en résulte que la probabilité d’un événement quelconque ne contenant pas 諸 est égale à 0. Si 行 = Rn , la fonction caractéristique de cette variable aléatoire certaine est: si 諸 = (m 1, ..., mn ). Des définitions du chapitre précédent il résulte qu’une variable aléatoire certaine est indépendante (au sens du calcul des probabilités ) de toute autre variable aléatoire et, en particulier, de toute variable aléatoire certaine.Variable et loi de BernoulliOn appelle variable de Bernoulli une variable pour laquelle l’ensemble image 行1 est égal à0, 1. C’est la variable utilisée dans le jeu de pile ou face (le nombre 1 étant attribué, par exemple, à face avec une probabilité p , et le nombre 0 étant attribué à pile avec la probabilité 1 漣 p = q ). Sa fonction caractéristique est q + p eiu .Loi binomialeDe la variable de Bernoulli on déduit la loi binomiale qui est la somme de n variables (indépendantes) de Bernoulli. La fonction caractéristique est:

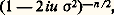

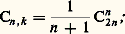

si 諸 = (m 1, ..., mn ). Des définitions du chapitre précédent il résulte qu’une variable aléatoire certaine est indépendante (au sens du calcul des probabilités ) de toute autre variable aléatoire et, en particulier, de toute variable aléatoire certaine.Variable et loi de BernoulliOn appelle variable de Bernoulli une variable pour laquelle l’ensemble image 行1 est égal à0, 1. C’est la variable utilisée dans le jeu de pile ou face (le nombre 1 étant attribué, par exemple, à face avec une probabilité p , et le nombre 0 étant attribué à pile avec la probabilité 1 漣 p = q ). Sa fonction caractéristique est q + p eiu .Loi binomialeDe la variable de Bernoulli on déduit la loi binomiale qui est la somme de n variables (indépendantes) de Bernoulli. La fonction caractéristique est: la probabilité est répartie sur l’ensemble0, 1, 2, ..., n, la probabilité de r étant Cr n p r q n size=1漣 r (probabilité de r succès sur n épreuves), le nombre Cr n étant le coefficient du binôme.Loi de Laplace-GaussLa loi de Laplace-Gauss, connue aussi sous le nom de loi normale , est celle dans laquelle 行1 = Rn , la loi de répartition de la variable n -dimensionnelle étant donnée par l’intégrale:

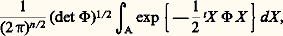

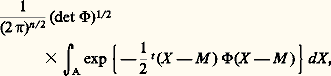

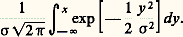

la probabilité est répartie sur l’ensemble0, 1, 2, ..., n, la probabilité de r étant Cr n p r q n size=1漣 r (probabilité de r succès sur n épreuves), le nombre Cr n étant le coefficient du binôme.Loi de Laplace-GaussLa loi de Laplace-Gauss, connue aussi sous le nom de loi normale , est celle dans laquelle 行1 = Rn , la loi de répartition de la variable n -dimensionnelle étant donnée par l’intégrale: dans le cas où la variable est dite centrée , c’est-à-dire d’espérance mathématique nulle; dans cette formule:

dans le cas où la variable est dite centrée , c’est-à-dire d’espérance mathématique nulle; dans cette formule: où X est la matrice colonne (vecteur) de composantes X1, ..., Xn , où tX désigne la matrice ligne transposée de la matrice colonne X et où 淋 est une matrice définie positive, dite matrice de distribution . Si cette matrice n’est pas singulière, la fonction caractéristique est:

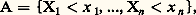

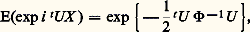

où X est la matrice colonne (vecteur) de composantes X1, ..., Xn , où tX désigne la matrice ligne transposée de la matrice colonne X et où 淋 est une matrice définie positive, dite matrice de distribution . Si cette matrice n’est pas singulière, la fonction caractéristique est: où U est la matrice colonne (vecteur) de composantes u 1, ..., un . La matrice de covariance C = (cij ), avec cij = E(Xi Xj ), est égale à 淋 size=1漣1; elle est naturellement elle aussi définie positive.Si, au lieu d’être centrée, la variable était telle que E(X ) = M , la loi de répartition serait:

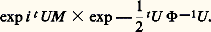

où U est la matrice colonne (vecteur) de composantes u 1, ..., un . La matrice de covariance C = (cij ), avec cij = E(Xi Xj ), est égale à 淋 size=1漣1; elle est naturellement elle aussi définie positive.Si, au lieu d’être centrée, la variable était telle que E(X ) = M , la loi de répartition serait: et la fonction caractéristique deviendrait:

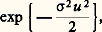

et la fonction caractéristique deviendrait: Dans le cas n = 1, on trouve, pour une variable unidimensionnelle de Laplace-Gauss non centrée, la loi de répartition:

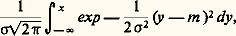

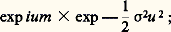

Dans le cas n = 1, on trouve, pour une variable unidimensionnelle de Laplace-Gauss non centrée, la loi de répartition: et la fonction caractéristique est:

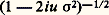

et la fonction caractéristique est: dans ces deux formules, 靖2 est la variance de cette variable.Loi de PoissonLa loi de Poisson, connue aussi sous le nom de loi des petites probabilités , est telle que 行1 = N, la probabilité attachée à l’entier n étant égale à:

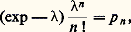

dans ces deux formules, 靖2 est la variance de cette variable.Loi de PoissonLa loi de Poisson, connue aussi sous le nom de loi des petites probabilités , est telle que 行1 = N, la probabilité attachée à l’entier n étant égale à: où est un paramètre positif. Bien entendu, on a:

où est un paramètre positif. Bien entendu, on a: La fonction caractéristique est:

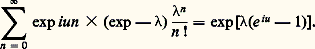

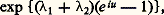

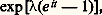

La fonction caractéristique est: On peut utiliser ici la notion de fonction génératrice , qui est égale à exp(z 漣 1). L’espérance mathématique de la loi de Poisson de même que la variance sont égales à.Loi de CauchyL’ensemble 行1 étant ici égal à R, la loi de Cauchy est la loi de répartition:

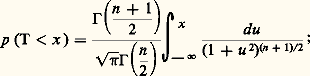

On peut utiliser ici la notion de fonction génératrice , qui est égale à exp(z 漣 1). L’espérance mathématique de la loi de Poisson de même que la variance sont égales à.Loi de CauchyL’ensemble 行1 étant ici égal à R, la loi de Cauchy est la loi de répartition: la fonction caractéristique est exp 漣 | u |. La figure 1 compare les représentations de la loi de Laplace-Gauss et de la loi de Cauchy. On est dans le cas où il n’existe aucun moment, et la fonction caractéristique n’est pas dérivable à l’origine.Loi uniformeDans le cas de la loi uniforme, 行1 est le segment [0, 1] et la probabilité d’un sous-ensemble (mesurable au sens de Lebesgue) de ce segment est égale à la mesure de Lebesgue de cet ensemble. La fonction caractéristique est ici:

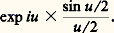

la fonction caractéristique est exp 漣 | u |. La figure 1 compare les représentations de la loi de Laplace-Gauss et de la loi de Cauchy. On est dans le cas où il n’existe aucun moment, et la fonction caractéristique n’est pas dérivable à l’origine.Loi uniformeDans le cas de la loi uniforme, 行1 est le segment [0, 1] et la probabilité d’un sous-ensemble (mesurable au sens de Lebesgue) de ce segment est égale à la mesure de Lebesgue de cet ensemble. La fonction caractéristique est ici: On trouvera dans les articles processus STOCHASTIQUES et STATISTIQUE d’autres lois usuelles dont des tables ont été dressées et qui sont d’usage courant.Les exemples précédents amènent à poser la question suivante: Comment savoir si une fonction est une fonction caractéristique? Il suffit évidemment que son inverse de Fourier soit une loi de répartition. C’est malheureusement une condition peu maniable et il n’en existe guère d’autre à l’heure actuelle. Signalons toutefois deux énoncés répondant à la question précédente.Théorème de Bochner . Pour qu’une fonction 﨏(u ) soit une fonction caractéristique, il faut et il suffit que 﨏(0) = 1, que 﨏 soit continue et définie positive , c’est-à-dire que l’on ait:

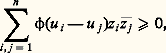

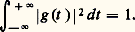

On trouvera dans les articles processus STOCHASTIQUES et STATISTIQUE d’autres lois usuelles dont des tables ont été dressées et qui sont d’usage courant.Les exemples précédents amènent à poser la question suivante: Comment savoir si une fonction est une fonction caractéristique? Il suffit évidemment que son inverse de Fourier soit une loi de répartition. C’est malheureusement une condition peu maniable et il n’en existe guère d’autre à l’heure actuelle. Signalons toutefois deux énoncés répondant à la question précédente.Théorème de Bochner . Pour qu’une fonction 﨏(u ) soit une fonction caractéristique, il faut et il suffit que 﨏(0) = 1, que 﨏 soit continue et définie positive , c’est-à-dire que l’on ait: quels que soient ui , uj réels et zi , zj complexes.Théorème de Khintchine . Pour que 﨏(u ) soit une fonction caractéristique, il faut et il suffit que 﨏(u ) soit, dans tout intervalle fini, la limite uniforme d’expressions de la forme:

quels que soient ui , uj réels et zi , zj complexes.Théorème de Khintchine . Pour que 﨏(u ) soit une fonction caractéristique, il faut et il suffit que 﨏(u ) soit, dans tout intervalle fini, la limite uniforme d’expressions de la forme: avec:

avec: 5. Arithmétique des lois de probabilitésOn désigne par l’expression arithmétique des lois de probabilités un ensemble de recherches et de résultats à l’origine desquels on relève principalement les noms de P. Levy, H. Cramer et Yu. Linnik. Les questions traitées tournent autour du problème suivant: X étant une variable aléatoire, peut-elle être décomposée comme une somme de deux variables aléatoires indépendantes X1 et X2? Il va de soi que cette décomposition est toujours possible si X1 ou X2 est une variable aléatoire certaine; on se placera donc toujours en dehors de ce cas trivial.Il convient tout d’abord de faire une remarque sur les lois définies dans le chapitre précédent. Si X1 et X2 sont toutes deux des variables de Laplace-Gauss, ou de Poisson, ou de Cauchy, et si elles sont indépendantes, leur somme est aussi respectivement de Laplace-Gauss, ou de Poisson, ou de Cauchy: c’est une conséquence de la forme des fonctions caractéristiques. Dans le cas de Laplace-Gauss, la fonction caractéristique de la somme sera de la forme:

5. Arithmétique des lois de probabilitésOn désigne par l’expression arithmétique des lois de probabilités un ensemble de recherches et de résultats à l’origine desquels on relève principalement les noms de P. Levy, H. Cramer et Yu. Linnik. Les questions traitées tournent autour du problème suivant: X étant une variable aléatoire, peut-elle être décomposée comme une somme de deux variables aléatoires indépendantes X1 et X2? Il va de soi que cette décomposition est toujours possible si X1 ou X2 est une variable aléatoire certaine; on se placera donc toujours en dehors de ce cas trivial.Il convient tout d’abord de faire une remarque sur les lois définies dans le chapitre précédent. Si X1 et X2 sont toutes deux des variables de Laplace-Gauss, ou de Poisson, ou de Cauchy, et si elles sont indépendantes, leur somme est aussi respectivement de Laplace-Gauss, ou de Poisson, ou de Cauchy: c’est une conséquence de la forme des fonctions caractéristiques. Dans le cas de Laplace-Gauss, la fonction caractéristique de la somme sera de la forme: fonction caractéristique d’une loi de Laplace-Gauss ayant pour vecteur moyen la somme des vecteurs moyens et pour matrice de covariance la somme des matrices de covariance; dans le cas de Poisson, la fonction caractéristique de la somme sera:

fonction caractéristique d’une loi de Laplace-Gauss ayant pour vecteur moyen la somme des vecteurs moyens et pour matrice de covariance la somme des matrices de covariance; dans le cas de Poisson, la fonction caractéristique de la somme sera: fonction caractéristique d’une loi de Poisson ayant pour paramètre la somme des paramètres des lois composantes. Dans le cas de Cauchy enfin, la fonction caractéristique de la somme sera exp漣 2 | u |, qui est la fonction caractéristique d’une loi de Cauchy à un changement d’échelle près. Il est remarquable que la réciproque de deux de ces résultats soit vraie: si X1 + X2 est une variable de Laplace-Gauss (resp. variable de Poisson) et si X1 et X2 sont indépendantes, X1 et X2 sont des variables de Laplace-Gauss (resp. variables de Poisson).Ce théorème, simple dans son énoncé, avait été pressenti dès 1934 par P. Levy qui avait indiqué certaines de ses conséquences. Il fut démontré par H. Cramer, en 1936, pour la loi de Laplace-Gauss et par D. Raikov, en 1937, pour la loi de Poisson. Le principe de la démonstration est le suivant: l’égalité X = X1 + X2, avec X1 et X2 indépendantes, entraîne l’égalité 﨏X(u ) = 﨏X1(u ) 﨏X2(u ); il s’agit donc de décomposer une fonction caractéristique de Laplace-Gauss (ou de Poisson) en un produit de deux fonctions caractéristiques, aucune de ces deux fonctions n’étant la fonction caractéristique d’une variable certaine. En utilisant des résultats de E. Picard, de É. Borel, de J. Hadamard et de S. Bernstein, on montre que cette décomposition en produit n’est possible que si X1 et X2 sont du même type que la variable initiale.On a pu aller plus loin dans ces théorèmes de décomposition en produits de fonctions caractéristiques. Posons:

fonction caractéristique d’une loi de Poisson ayant pour paramètre la somme des paramètres des lois composantes. Dans le cas de Cauchy enfin, la fonction caractéristique de la somme sera exp漣 2 | u |, qui est la fonction caractéristique d’une loi de Cauchy à un changement d’échelle près. Il est remarquable que la réciproque de deux de ces résultats soit vraie: si X1 + X2 est une variable de Laplace-Gauss (resp. variable de Poisson) et si X1 et X2 sont indépendantes, X1 et X2 sont des variables de Laplace-Gauss (resp. variables de Poisson).Ce théorème, simple dans son énoncé, avait été pressenti dès 1934 par P. Levy qui avait indiqué certaines de ses conséquences. Il fut démontré par H. Cramer, en 1936, pour la loi de Laplace-Gauss et par D. Raikov, en 1937, pour la loi de Poisson. Le principe de la démonstration est le suivant: l’égalité X = X1 + X2, avec X1 et X2 indépendantes, entraîne l’égalité 﨏X(u ) = 﨏X1(u ) 﨏X2(u ); il s’agit donc de décomposer une fonction caractéristique de Laplace-Gauss (ou de Poisson) en un produit de deux fonctions caractéristiques, aucune de ces deux fonctions n’étant la fonction caractéristique d’une variable certaine. En utilisant des résultats de E. Picard, de É. Borel, de J. Hadamard et de S. Bernstein, on montre que cette décomposition en produit n’est possible que si X1 et X2 sont du même type que la variable initiale.On a pu aller plus loin dans ces théorèmes de décomposition en produits de fonctions caractéristiques. Posons: avec 見1 礪 0, 見2 礪 0. Yu. Linnik a établi que, si 﨏X(u ) est fonction caractéristique de Laplace-Gauss, il en est de même de 﨏X1(u ) et de 﨏X2(u ), et D. Dugué a montré le même résultat en remplaçant la loi de Laplace-Gauss par celle de Poisson. Enfin, Yu. Linnik a donné le théorème suivant qui regroupe tous ces résultats: dans l’égalité ci-dessus, si 﨏X(u ) est un produit d’une fonction caractéristique de Laplace-Gauss par une fonction caractéristique de Poisson, il en est de même pour 﨏X1(u ) et 﨏X2(u ).Ces résultats d’une grande élégance ne peuvent être étendus à la loi de Cauchy: on connaît des exemples où:

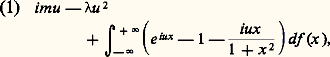

avec 見1 礪 0, 見2 礪 0. Yu. Linnik a établi que, si 﨏X(u ) est fonction caractéristique de Laplace-Gauss, il en est de même de 﨏X1(u ) et de 﨏X2(u ), et D. Dugué a montré le même résultat en remplaçant la loi de Laplace-Gauss par celle de Poisson. Enfin, Yu. Linnik a donné le théorème suivant qui regroupe tous ces résultats: dans l’égalité ci-dessus, si 﨏X(u ) est un produit d’une fonction caractéristique de Laplace-Gauss par une fonction caractéristique de Poisson, il en est de même pour 﨏X1(u ) et 﨏X2(u ).Ces résultats d’une grande élégance ne peuvent être étendus à la loi de Cauchy: on connaît des exemples où: sans que 﨏X1 et 﨏X2 soient de cette forme.Ces théorèmes amorcent les recherches de décomposition: ce sont (tout au moins pour les lois de Laplace-Gauss et de Poisson) des théorèmes d’unicité. On a mis en évidence des cas d’impossibilité: il est facile d’établir qu’une variable de Bernoulli ne peut être décomposée de cette façon. Un problème particulièrement intéressant est celui des lois indéfiniment divisibles , qui a été posé et résolu par P. Levy: trouver toutes les fonctions caractéristiques 﨏(u ) telles que [ 﨏(u )] size=1見 soit également fonction caractéristique quel que soit 見 礪 0. La variable aléatoire dont 﨏(u ) est fonction caractéristique pourra alors être considérée comme une somme de variables aléatoires indépendantes «arbitrairement petites», c’est-à-dire s’écartant arbitrairement peu d’une variable certaine. Ces lois indéfiniment divisibles ont une grande importance dans l’étude des fonctions aléatoires (cf. processus STOCHASTIQUES). Pour qu’une variable aléatoire soit indéfiniment divisible, il est nécessaire et suffisant que le logarithme de sa fonction caractéristique soit de la forme:

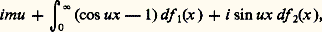

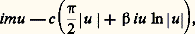

sans que 﨏X1 et 﨏X2 soient de cette forme.Ces théorèmes amorcent les recherches de décomposition: ce sont (tout au moins pour les lois de Laplace-Gauss et de Poisson) des théorèmes d’unicité. On a mis en évidence des cas d’impossibilité: il est facile d’établir qu’une variable de Bernoulli ne peut être décomposée de cette façon. Un problème particulièrement intéressant est celui des lois indéfiniment divisibles , qui a été posé et résolu par P. Levy: trouver toutes les fonctions caractéristiques 﨏(u ) telles que [ 﨏(u )] size=1見 soit également fonction caractéristique quel que soit 見 礪 0. La variable aléatoire dont 﨏(u ) est fonction caractéristique pourra alors être considérée comme une somme de variables aléatoires indépendantes «arbitrairement petites», c’est-à-dire s’écartant arbitrairement peu d’une variable certaine. Ces lois indéfiniment divisibles ont une grande importance dans l’étude des fonctions aléatoires (cf. processus STOCHASTIQUES). Pour qu’une variable aléatoire soit indéfiniment divisible, il est nécessaire et suffisant que le logarithme de sa fonction caractéristique soit de la forme: où m est un nombre réel, positif ou nul, f étant non décroissante de 漣 秊 à 0 et de 0 à + 秊 (nulle pour x = 梁 秊) et telle que l’intégrale 咽x 2 df (x ) soit finie sur tout intervalle fini. Dans ces conditions, la représentation de la fonction caractéristique d’une loi indéfiniment divisible est unique. Si f (x ) = 0, on retrouve la loi de Laplace-Gauss unidimensionnelle. Si = 0 et si f (x ) est constant, sauf pour x = 1 où f (x ) a un saut égal à k , avec m = k /2, on retrouve la loi de Poisson de paramètre k . D’une manière générale, une variable aléatoire indéfiniment divisible est la somme d’une variable certaine, d’une variable de Laplace-Gauss et d’une infinité de variables de Poisson infiniment petites, chacune de ces variables prenant l’ensemble des valeurs 0, x , 2 x , ..., nx , ..., 漣 秊 麗 x 麗 + 秊, toutes ces variables étant indépendantes entre elles.Les deux lois de Laplace-Gauss et de Poisson jouent donc un rôle fondamental dans la théorie des lois indéfiniment divisibles. On voit aisément que la loi de Cauchy est l’une de ces lois. Comme la loi de Laplace-Gauss, elle fait partie d’un sous-ensemble de l’ensemble des lois indéfiniment divisibles auxquelles Levy a donné le nom de lois stables . Ce sont les lois telles que, X1 et X2 étant deux variables indépendantes dépendant de cette loi et C1 et C2 étant deux constantes positives quelconques, on ait:

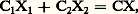

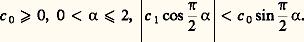

où m est un nombre réel, positif ou nul, f étant non décroissante de 漣 秊 à 0 et de 0 à + 秊 (nulle pour x = 梁 秊) et telle que l’intégrale 咽x 2 df (x ) soit finie sur tout intervalle fini. Dans ces conditions, la représentation de la fonction caractéristique d’une loi indéfiniment divisible est unique. Si f (x ) = 0, on retrouve la loi de Laplace-Gauss unidimensionnelle. Si = 0 et si f (x ) est constant, sauf pour x = 1 où f (x ) a un saut égal à k , avec m = k /2, on retrouve la loi de Poisson de paramètre k . D’une manière générale, une variable aléatoire indéfiniment divisible est la somme d’une variable certaine, d’une variable de Laplace-Gauss et d’une infinité de variables de Poisson infiniment petites, chacune de ces variables prenant l’ensemble des valeurs 0, x , 2 x , ..., nx , ..., 漣 秊 麗 x 麗 + 秊, toutes ces variables étant indépendantes entre elles.Les deux lois de Laplace-Gauss et de Poisson jouent donc un rôle fondamental dans la théorie des lois indéfiniment divisibles. On voit aisément que la loi de Cauchy est l’une de ces lois. Comme la loi de Laplace-Gauss, elle fait partie d’un sous-ensemble de l’ensemble des lois indéfiniment divisibles auxquelles Levy a donné le nom de lois stables . Ce sont les lois telles que, X1 et X2 étant deux variables indépendantes dépendant de cette loi et C1 et C2 étant deux constantes positives quelconques, on ait: où C est une constante positive fonction de C1 et C2 et où X est une variable dépendant de la même loi. Pour ces lois, la fonction caractéristique est de la forme:

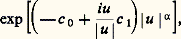

où C est une constante positive fonction de C1 et C2 et où X est une variable dépendant de la même loi. Pour ces lois, la fonction caractéristique est de la forme: avec:

avec: Une loi semi stable est telle que sa fonction caractéristique satisfasse à l’équation fonctionnelle:

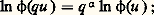

Une loi semi stable est telle que sa fonction caractéristique satisfasse à l’équation fonctionnelle: dans ce cas, le logarithme de la fonction caractéristique a pour expression:

dans ce cas, le logarithme de la fonction caractéristique a pour expression: où xf 1(x ) et xf 2(x ) sont des fonctions périodiques de ln x , la seconde ayant une valeur moyenne nulle et où f 1(x ) + f 2(x ) et f 1(x ) 漣 f 2(x ) sont non décroissantes.Une loi quasi stable est telle que, si X1 et X2 sont des variables indépendantes obéissant à cette loi et si C1 et C2 sont des constantes, on ait:

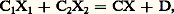

où xf 1(x ) et xf 2(x ) sont des fonctions périodiques de ln x , la seconde ayant une valeur moyenne nulle et où f 1(x ) + f 2(x ) et f 1(x ) 漣 f 2(x ) sont non décroissantes.Une loi quasi stable est telle que, si X1 et X2 sont des variables indépendantes obéissant à cette loi et si C1 et C2 sont des constantes, on ait: avec X obéissant à la même loi et où C et D sont des constantes. Si C = C1 + C2, le logarithme de la fonction caractéristique est:

avec X obéissant à la même loi et où C et D sont des constantes. Si C = C1 + C2, le logarithme de la fonction caractéristique est: avec c 礪 0 et | 廓 | 諒 1. Si C C1 + C2, la loi quasi stable la plus générale s’obtient en ajoutant une variable certaine à une variable aléatoire dépendant d’une loi stable. P. Levy a également proposé le théorème suivant qui répond à une question posée par Khintchine: Pour qu’une loi puisse être limite de lois de variables aléatoires Sn /n , où Sn est la n -ième somme d’une série à termes aléatoires indépendants etn une suite de nombres certains tendant vers l’infini avec limn +1/n = 1, il est nécessaire et suffisant que cette loi soit indéfiniment divisible avec, dans la représentation (1) donnée ci-dessus, f (x ) pour x 麗 0 et 漣 f (x ) pour x 礪 0, fonctions convexes de ln | x | .6. Inégalités et équivalencesLa plus ancienne des inégalités utilisées en calcul des probabilités est l’inégalité de Bienaymé-Tchebychev ; si on pose:

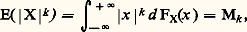

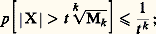

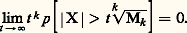

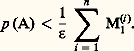

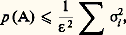

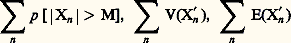

avec c 礪 0 et | 廓 | 諒 1. Si C C1 + C2, la loi quasi stable la plus générale s’obtient en ajoutant une variable certaine à une variable aléatoire dépendant d’une loi stable. P. Levy a également proposé le théorème suivant qui répond à une question posée par Khintchine: Pour qu’une loi puisse être limite de lois de variables aléatoires Sn /n , où Sn est la n -ième somme d’une série à termes aléatoires indépendants etn une suite de nombres certains tendant vers l’infini avec limn +1/n = 1, il est nécessaire et suffisant que cette loi soit indéfiniment divisible avec, dans la représentation (1) donnée ci-dessus, f (x ) pour x 麗 0 et 漣 f (x ) pour x 礪 0, fonctions convexes de ln | x | .6. Inégalités et équivalencesLa plus ancienne des inégalités utilisées en calcul des probabilités est l’inégalité de Bienaymé-Tchebychev ; si on pose: en supposant bien entendu que ce moment d’ordre k existe, on a:

en supposant bien entendu que ce moment d’ordre k existe, on a: en fait, on a même, d’une manière plus précise mais moins utilisable (car la vitesse avec laquelle la limite est atteinte dépend de la loi de probabilité):

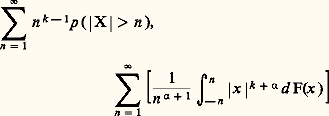

en fait, on a même, d’une manière plus précise mais moins utilisable (car la vitesse avec laquelle la limite est atteinte dépend de la loi de probabilité): On établit de même, et c’est un résultat très utile pour l’étude des lois des grands nombres, que l’existence du k -ième moment en valeur absolue E(| X | k ) équivaut à la convergence des deux séries:

On établit de même, et c’est un résultat très utile pour l’étude des lois des grands nombres, que l’existence du k -ième moment en valeur absolue E(| X | k ) équivaut à la convergence des deux séries: pour 見 礪 0 et k 礪 0. Dans le même ordre d’idée, si:

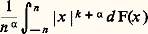

pour 見 礪 0 et k 礪 0. Dans le même ordre d’idée, si: le quotient:

le quotient: tend vers 0 pour 見 礪 0, k 閭 0. Ces inégalités conduisent à des majorations utilisées dans l’étude de «lois des grands nombres».De la définition de la variance d’une variable aléatoire on déduit facilement que la variance de la somme de n variables indépendantes est la somme des variances, d’où, en appliquant l’inégalité de Bienaymé-Tchebychev,

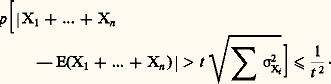

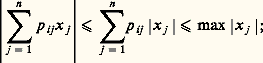

tend vers 0 pour 見 礪 0, k 閭 0. Ces inégalités conduisent à des majorations utilisées dans l’étude de «lois des grands nombres».De la définition de la variance d’une variable aléatoire on déduit facilement que la variance de la somme de n variables indépendantes est la somme des variances, d’où, en appliquant l’inégalité de Bienaymé-Tchebychev, Soit maintenant X1, ..., Xn des variables (indépendantes ou non). On pose alors E(| Xi | ) = M1(i ). Considérant l’événement:

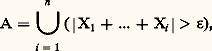

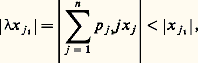

Soit maintenant X1, ..., Xn des variables (indépendantes ou non). On pose alors E(| Xi | ) = M1(i ). Considérant l’événement: on a l’inégalité:

on a l’inégalité: Kolmogorov a donné de ce même événement la majoration suivante:

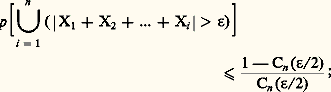

Kolmogorov a donné de ce même événement la majoration suivante: les hypothèses étant que X1, ..., Xn sont indépendantes et toutes centrées, c’est-à-dire E(Xi ) = 0 pour i = 1, ..., n , avec E(Xi 2) = 靖i 2. Ce résultat est indispensable pour démontrer la loi forte des grands nombres (ou loi presque sûre des grands nombres) ainsi que la loi du logarithme itéré due à Khintchine.Ces trois dernières inégalités supposent l’existence de moments. P. Levy a établi une inégalité portant sur la même probabilité, mais qui ne suppose l’existence d’aucun moment. Les variables aléatoires X1, ..., Xn étant indépendantes, on posera Sn = X1 + ... + Xn et on désignera par Cn la fonction de concentration de Sn (cf. chap. 3); supposons réalisée la condition suivante: les intervalles fermés de longueur égale à 﨎/2 et de probabilité maximale pour Sn , Sn 漣 Sn size=1漣 1, ..., Sn 漣 S1 ont l’origine comme point intérieur. On a alors:

les hypothèses étant que X1, ..., Xn sont indépendantes et toutes centrées, c’est-à-dire E(Xi ) = 0 pour i = 1, ..., n , avec E(Xi 2) = 靖i 2. Ce résultat est indispensable pour démontrer la loi forte des grands nombres (ou loi presque sûre des grands nombres) ainsi que la loi du logarithme itéré due à Khintchine.Ces trois dernières inégalités supposent l’existence de moments. P. Levy a établi une inégalité portant sur la même probabilité, mais qui ne suppose l’existence d’aucun moment. Les variables aléatoires X1, ..., Xn étant indépendantes, on posera Sn = X1 + ... + Xn et on désignera par Cn la fonction de concentration de Sn (cf. chap. 3); supposons réalisée la condition suivante: les intervalles fermés de longueur égale à 﨎/2 et de probabilité maximale pour Sn , Sn 漣 Sn size=1漣 1, ..., Sn 漣 S1 ont l’origine comme point intérieur. On a alors: cette inégalité a permis d’établir un théorème important, dont il sera question au chapitre 8, sur la convergence des séries aléatoires.Signalons enfin une inégalité portant sur les fonctions caractéristiques:

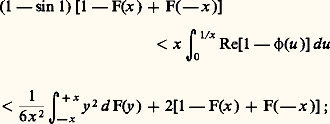

cette inégalité a permis d’établir un théorème important, dont il sera question au chapitre 8, sur la convergence des séries aléatoires.Signalons enfin une inégalité portant sur les fonctions caractéristiques: cette inégalité est utilisée au chapitre 8 pour établir le théorème sur la limite de fonctions caractéristiques.7. Topologie aléatoireLe calcul des probabilités distingue plusieurs sortes de convergences, dont la convergence en loi, la convergence en probabilité et la convergence presque sûre.Convergence en loiOn dit qu’une suite (Xn ) de variables aléatoires converge en loi vers une variable aléatoire X si les lois des Xn tendent vers la loi de X, sauf peut-être aux points de discontinuité de cette dernière. Comme on l’a vu au chapitre 3, la convergence en loi et la convergence en fonction caractéristique sont équivalentes. Cette convergence, que l’on appelle parfois aussi convergence légale et qui est analogue à la convergence vague de la théorie de la mesure, n’entraîne rien a priori sur la suite des variables Xn elles-mêmes: la suite des lois peut converger sans que la suite des variables converge (en un sens qui va être précisé).Convergence en probabilitéOn dit qu’une suite (Xn ) de variables converge en probabilité vers une variable X si:

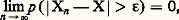

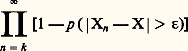

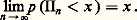

cette inégalité est utilisée au chapitre 8 pour établir le théorème sur la limite de fonctions caractéristiques.7. Topologie aléatoireLe calcul des probabilités distingue plusieurs sortes de convergences, dont la convergence en loi, la convergence en probabilité et la convergence presque sûre.Convergence en loiOn dit qu’une suite (Xn ) de variables aléatoires converge en loi vers une variable aléatoire X si les lois des Xn tendent vers la loi de X, sauf peut-être aux points de discontinuité de cette dernière. Comme on l’a vu au chapitre 3, la convergence en loi et la convergence en fonction caractéristique sont équivalentes. Cette convergence, que l’on appelle parfois aussi convergence légale et qui est analogue à la convergence vague de la théorie de la mesure, n’entraîne rien a priori sur la suite des variables Xn elles-mêmes: la suite des lois peut converger sans que la suite des variables converge (en un sens qui va être précisé).Convergence en probabilitéOn dit qu’une suite (Xn ) de variables converge en probabilité vers une variable X si: quel que soit 﨎 礪 0. Cette convergence est l’analogue de la convergence en mesure de la théorie de la mesure [cf. INTÉGRATION ET MESURE].Convergence presque sûreLa convergence presque sûre est l’analogue de la convergence presque partout en théorie de la mesure. Une suite de variables Xn converge presque sûrement (ou presque certainement) vers une variable X si:

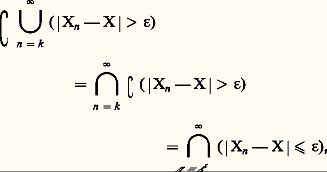

quel que soit 﨎 礪 0. Cette convergence est l’analogue de la convergence en mesure de la théorie de la mesure [cf. INTÉGRATION ET MESURE].Convergence presque sûreLa convergence presque sûre est l’analogue de la convergence presque partout en théorie de la mesure. Une suite de variables Xn converge presque sûrement (ou presque certainement) vers une variable X si: quel que soit 﨎 礪 0. En utilisant l’inégalité de Boole (cf. chap. 2), on voit que:

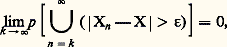

quel que soit 﨎 礪 0. En utilisant l’inégalité de Boole (cf. chap. 2), on voit que: on en déduit que la convergence presque sûre entraîne la convergence en probabilité et que la convergence de la série:

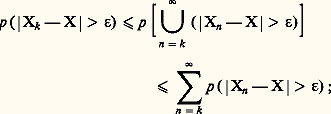

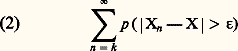

on en déduit que la convergence presque sûre entraîne la convergence en probabilité et que la convergence de la série: conduit à la convergence presque sûre. Si la série (2) converge, on dit parfois que la suite (Xn ) converge presque complètement sûrement vers X. Cette condition est en général plus forte que la convergence presque sûre, mais elle lui est équivalente quand les variables Xn 漣 X sont indépendantes dans leur ensemble. En effet, on a, du point de vue ensembliste,

conduit à la convergence presque sûre. Si la série (2) converge, on dit parfois que la suite (Xn ) converge presque complètement sûrement vers X. Cette condition est en général plus forte que la convergence presque sûre, mais elle lui est équivalente quand les variables Xn 漣 X sont indépendantes dans leur ensemble. En effet, on a, du point de vue ensembliste, et, d’après la définition de l’indépendance, si les Xn 漣 X sont indépendants, on pourra écrire les égalités:

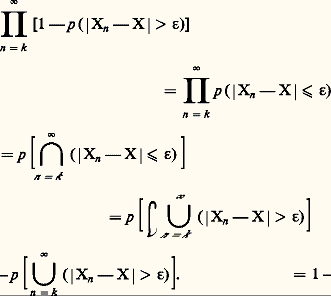

et, d’après la définition de l’indépendance, si les Xn 漣 X sont indépendants, on pourra écrire les égalités: Donc, si les Xn 漣 X sont indépendants et si Xn converge presque sûrement vers X, le produit infini:

Donc, si les Xn 漣 X sont indépendants et si Xn converge presque sûrement vers X, le produit infini: est convergent, ce qui équivaut à la convergence de la série (2), pour tout 﨎 礪 0.Comparaison des convergencesOn a donc toute une hiérarchie de convergences: la convergence presque complètement sûre implique la convergence presque sûre, laquelle implique la convergence en probabilité, celle-ci entraînant la convergence en loi (ce dernier fait s’établit facilement). Signalons que, si X est une variable certaine, la convergence en loi de Xn vers X conduit à la convergence en probabilité de Xn vers X. Si, d’autre part, tous les Xn sont des variables certaines, toutes ces convergences sont confondues au sens ordinaire de la convergence en analyse certaine. Le calcul des probabilités est donc, à ce point de vue, une extension de l’analyse certaine.Voici maintenant un mode de convergence qui est fréquemment utilisé en calcul des probabilités en raison de la très grande importance des espaces de fonctions de carré sommable. On dit qu’une suite de variables aléatoires Xn converge en moyenne quadratique vers la variable X si:

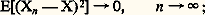

est convergent, ce qui équivaut à la convergence de la série (2), pour tout 﨎 礪 0.Comparaison des convergencesOn a donc toute une hiérarchie de convergences: la convergence presque complètement sûre implique la convergence presque sûre, laquelle implique la convergence en probabilité, celle-ci entraînant la convergence en loi (ce dernier fait s’établit facilement). Signalons que, si X est une variable certaine, la convergence en loi de Xn vers X conduit à la convergence en probabilité de Xn vers X. Si, d’autre part, tous les Xn sont des variables certaines, toutes ces convergences sont confondues au sens ordinaire de la convergence en analyse certaine. Le calcul des probabilités est donc, à ce point de vue, une extension de l’analyse certaine.Voici maintenant un mode de convergence qui est fréquemment utilisé en calcul des probabilités en raison de la très grande importance des espaces de fonctions de carré sommable. On dit qu’une suite de variables aléatoires Xn converge en moyenne quadratique vers la variable X si: il résulte de l’inégalité de Bienaymé-Tchebychev (cf. chap. 6) que, si la suite Xn converge en moyenne quadratique vers X, alors Xn converge en probabilité vers X. La réciproque n’est pas exacte: la suite Xn peut même converger en probabilité vers X sans que les variables Xn 漣 X aient un moment d’ordre 2.On peut établir les deux théorèmes suivants, attribués à Slutsky:Théorème 1. Si une suite (Xn ) converge en probabilité vers X, on peut extraire de cette suite une suite partielle convergeant presque complètement sûrement.Théorème 2. Si une suite de variables Xn converge mutuellement en probabilité, c’est-à-dire est telle que, quel que soit 﨎 礪 0, il existe N tel que m 礪 n 礪 N entraîne p (| Xm 漣 Xn | 礪 﨎) 麗 﨎, alors il existe une variable aléatoire X telle que Xn converge en probabilité vers X.On peut se demander dans quelle mesure ces différentes convergences sont compatibles avec une norme ou une distance. La convergence presque sûre est incompatible avec une distance, et la convergence en probabilité est compatible avec une distance mais incompatible avec une norme. On utilise souvent une distance de deux variables aléatoires X et Y due à Ky-Fan: c’est la borne inférieure des x 礪 0 tels que p (| X 漣 Y | 礪 x ) 麗 x .L’historique de toutes ces notions coïncide avec l’évolution du calcul des probabilités. La notion de convergence en probabilité était connue de Bernoulli, sans avoir été explicitée par lui. Il a fallu attendre le début du XXe siècle pour dégager la notion de convergence presque sûre: elle est due essentiellement à Borel. À la même époque, Cantelli a signalé l’importance de cette acquisition. Avec juste raison, Fréchet a qualifié cette définition de «principale découverte en calcul des probabilités depuis Laplace».Il est important d’attirer l’attention sur un fait qui concerne les applications du calcul des probabilités et en particulier la statistique. La convergence en probabilité concerne la probabilité de réalisation d’un événement, probabilité qui doit tendre vers 1 pour que la convergence soit réalisée. La convergence presque sûre concerne la probabilité de réalisation d’une infinité d’éléments, alors que l’expérience ne peut fournir une infinité d’événements. Par conséquent, la convergence en probabilité sera celle du statisticien utilisateur de la statistique pour la critique de l’expérience, tandis que la convergence presque sûre sera davantage celle du théoricien du calcul des probabilités.8. Lois des grands nombres et théorème central limiteLes théorèmes qui vont être énoncés maintenant sont des applications de toutes les notions précédentes. Ils sont très utiles dans les problèmes d’estimation.Lois des grands nombresLes «lois des grands nombres» concernent des ensembles de n variables aléatoires X1, ..., Xn indépendantes, ayant même loi de probabilité (isonomes , selon un mot récemment introduit dans la terminologie); le vocabulaire anglo-saxon désigne un tel ensemble sous le nom de sample , qui signifie échantillon. On a ainsi une cascade de théorèmes de plus en plus «fins» concernant le comportement de la moyenne:

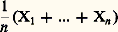

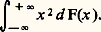

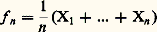

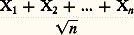

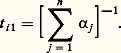

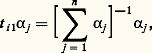

il résulte de l’inégalité de Bienaymé-Tchebychev (cf. chap. 6) que, si la suite Xn converge en moyenne quadratique vers X, alors Xn converge en probabilité vers X. La réciproque n’est pas exacte: la suite Xn peut même converger en probabilité vers X sans que les variables Xn 漣 X aient un moment d’ordre 2.On peut établir les deux théorèmes suivants, attribués à Slutsky:Théorème 1. Si une suite (Xn ) converge en probabilité vers X, on peut extraire de cette suite une suite partielle convergeant presque complètement sûrement.Théorème 2. Si une suite de variables Xn converge mutuellement en probabilité, c’est-à-dire est telle que, quel que soit 﨎 礪 0, il existe N tel que m 礪 n 礪 N entraîne p (| Xm 漣 Xn | 礪 﨎) 麗 﨎, alors il existe une variable aléatoire X telle que Xn converge en probabilité vers X.On peut se demander dans quelle mesure ces différentes convergences sont compatibles avec une norme ou une distance. La convergence presque sûre est incompatible avec une distance, et la convergence en probabilité est compatible avec une distance mais incompatible avec une norme. On utilise souvent une distance de deux variables aléatoires X et Y due à Ky-Fan: c’est la borne inférieure des x 礪 0 tels que p (| X 漣 Y | 礪 x ) 麗 x .L’historique de toutes ces notions coïncide avec l’évolution du calcul des probabilités. La notion de convergence en probabilité était connue de Bernoulli, sans avoir été explicitée par lui. Il a fallu attendre le début du XXe siècle pour dégager la notion de convergence presque sûre: elle est due essentiellement à Borel. À la même époque, Cantelli a signalé l’importance de cette acquisition. Avec juste raison, Fréchet a qualifié cette définition de «principale découverte en calcul des probabilités depuis Laplace».Il est important d’attirer l’attention sur un fait qui concerne les applications du calcul des probabilités et en particulier la statistique. La convergence en probabilité concerne la probabilité de réalisation d’un événement, probabilité qui doit tendre vers 1 pour que la convergence soit réalisée. La convergence presque sûre concerne la probabilité de réalisation d’une infinité d’éléments, alors que l’expérience ne peut fournir une infinité d’événements. Par conséquent, la convergence en probabilité sera celle du statisticien utilisateur de la statistique pour la critique de l’expérience, tandis que la convergence presque sûre sera davantage celle du théoricien du calcul des probabilités.8. Lois des grands nombres et théorème central limiteLes théorèmes qui vont être énoncés maintenant sont des applications de toutes les notions précédentes. Ils sont très utiles dans les problèmes d’estimation.Lois des grands nombresLes «lois des grands nombres» concernent des ensembles de n variables aléatoires X1, ..., Xn indépendantes, ayant même loi de probabilité (isonomes , selon un mot récemment introduit dans la terminologie); le vocabulaire anglo-saxon désigne un tel ensemble sous le nom de sample , qui signifie échantillon. On a ainsi une cascade de théorèmes de plus en plus «fins» concernant le comportement de la moyenne: de ces n variables aléatoires.Théorème 1. Pour que ( Xi )/n converge en probabilité vers a certain, il est nécessaire et suffisant que la fonction caractéristique 﨏(u ) de la variable soit dérivable à l’origine avec a = 漣 i 﨏 (0), ce qui se traduit sur la fonction de répartition F(x ) par l’ensemble des deux conditions:

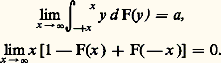

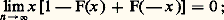

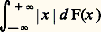

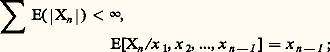

de ces n variables aléatoires.Théorème 1. Pour que ( Xi )/n converge en probabilité vers a certain, il est nécessaire et suffisant que la fonction caractéristique 﨏(u ) de la variable soit dérivable à l’origine avec a = 漣 i 﨏 (0), ce qui se traduit sur la fonction de répartition F(x ) par l’ensemble des deux conditions: Théorème 2. Pour que ( Xi )/n converge presque sûrement vers a certain, il est nécessaire et suffisant que:

Théorème 2. Pour que ( Xi )/n converge presque sûrement vers a certain, il est nécessaire et suffisant que: et que, de plus,

et que, de plus, converge. Sur la fonction de répartition, ces conditions se traduisent par le fait que l’intégrale:

converge. Sur la fonction de répartition, ces conditions se traduisent par le fait que l’intégrale: est convergente, avec:

est convergente, avec: Théorème 3. Pour que ( Xi )/n converge presque complètement sûrement vers a certain, il est nécessaire et suffisant que 漣 i 﨏 (0) = a et que la fonction caractéristique ait une dérivée seconde. Pour la fonction de répartition, cela entraîne l’égalité:

Théorème 3. Pour que ( Xi )/n converge presque complètement sûrement vers a certain, il est nécessaire et suffisant que 漣 i 﨏 (0) = a et que la fonction caractéristique ait une dérivée seconde. Pour la fonction de répartition, cela entraîne l’égalité: et la convergence de:

et la convergence de: Un cas particulier important est celui de la variable de Bernoulli qui décrit une épreuve de pile ou face (cf. chap. 4). Dans ce cas, X1 + ... + Xn est le nombre aléatoire de fois où l’on aura obtenu face au cours de n épreuves et:

Un cas particulier important est celui de la variable de Bernoulli qui décrit une épreuve de pile ou face (cf. chap. 4). Dans ce cas, X1 + ... + Xn est le nombre aléatoire de fois où l’on aura obtenu face au cours de n épreuves et: sera la fréquence de face au cours de ces n épreuves. Cette variable étant bornée, les moments de tous ordres existent et les trois théorèmes précédents peuvent s’appliquer, le nombre a étant ici égal à la probabilité p d’obtenir face. Le premier théorème signifie que l’on peut trouver N tel que, si n est supérieur à N, il y a une probabilité arbitrairement petite pour que | fn 漣 p | 礪 﨎, quel que soit 﨎 礪 0. Le deuxième implique qu’il y a une probabilité égale à 1 pour que la suite infinie des fréquences f 1, f 2, ..., fn , ... tende vers p. Enfin, le troisième indique qu’il y a encore une probabilité égale à 1 pour que la suite f 1(1), f 2(2), ..., f n (n ), ... des fréquences tende vers p , la fréquence f n (n ) étant calculée sur des «paquets» de n épreuves entièrement nouvelles pour chaque valeur de l’indice. On voit donc [cf. STATISTIQUE] que la fréquence fn peut être considérée comme une estimation de la grandeur inconnue p. Nous avons évoqué ce problème dans le chapitre 2 consacré aux bases concrètes du calcul des probabilités.Théorème central limite et loi de PoissonLe théorème central limite est un théorème de convergence en loi (cf. chap. 7). Soit encore n variables constituant un échantillon, la fonction caractéristique des variables ayant une dérivée nulle à l’origine et une dérivée seconde 﨏 (0) = 漣 靖2 (ce qui implique l’existence d’un moment d’ordre 2 égal à 靖2). La fonction caractéristique de:

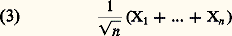

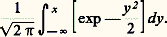

sera la fréquence de face au cours de ces n épreuves. Cette variable étant bornée, les moments de tous ordres existent et les trois théorèmes précédents peuvent s’appliquer, le nombre a étant ici égal à la probabilité p d’obtenir face. Le premier théorème signifie que l’on peut trouver N tel que, si n est supérieur à N, il y a une probabilité arbitrairement petite pour que | fn 漣 p | 礪 﨎, quel que soit 﨎 礪 0. Le deuxième implique qu’il y a une probabilité égale à 1 pour que la suite infinie des fréquences f 1, f 2, ..., fn , ... tende vers p. Enfin, le troisième indique qu’il y a encore une probabilité égale à 1 pour que la suite f 1(1), f 2(2), ..., f n (n ), ... des fréquences tende vers p , la fréquence f n (n ) étant calculée sur des «paquets» de n épreuves entièrement nouvelles pour chaque valeur de l’indice. On voit donc [cf. STATISTIQUE] que la fréquence fn peut être considérée comme une estimation de la grandeur inconnue p. Nous avons évoqué ce problème dans le chapitre 2 consacré aux bases concrètes du calcul des probabilités.Théorème central limite et loi de PoissonLe théorème central limite est un théorème de convergence en loi (cf. chap. 7). Soit encore n variables constituant un échantillon, la fonction caractéristique des variables ayant une dérivée nulle à l’origine et une dérivée seconde 﨏 (0) = 漣 靖2 (ce qui implique l’existence d’un moment d’ordre 2 égal à 靖2). La fonction caractéristique de: est égale à:

est égale à: sous les conditions indiquées, elle tend vers:

sous les conditions indiquées, elle tend vers: quand n augmente indéfiniment. D’après ce que l’on a vu au chapitre 3, la loi de la variable aléatoire (3) tend donc vers la loi de Laplace-Gauss:

quand n augmente indéfiniment. D’après ce que l’on a vu au chapitre 3, la loi de la variable aléatoire (3) tend donc vers la loi de Laplace-Gauss: De nombreuses extensions, en particulier celle de Liapounov, ont été données à ce résultat: elles concernent des hypothèses moins restrictives sur les lois des variables Xi . Cette loi de Laplace-Gauss est d’un emploi fréquent en physique et en particulier en métrologie; on l’appelle souvent loi des erreurs : c’est la loi à laquelle obéissent les différentes mesures entachées d’erreurs d’une même grandeur. Ces erreurs sont provoquées par un très grand nombre de causes d’une importance et d’un comportement analogues, indépendantes les unes des autres. Ce raisonnement justifie la phrase attribuée à Lippmann: «Les expérimentateurs considèrent cette loi comme un résultat théorique et les théoriciens comme un fait expérimental.»La loi de Poisson peut, elle aussi, être tenue pour une loi limite. Soit n variables indépendantes de Bernoulli ayant toutes la même loi (0 avec la probabilité qn et 1 avec la probabilité pn = 1 漣 qn ). La somme de ces n variables est le nombre de succès en n épreuves; sa fonction caractéristique est:

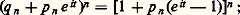

De nombreuses extensions, en particulier celle de Liapounov, ont été données à ce résultat: elles concernent des hypothèses moins restrictives sur les lois des variables Xi . Cette loi de Laplace-Gauss est d’un emploi fréquent en physique et en particulier en métrologie; on l’appelle souvent loi des erreurs : c’est la loi à laquelle obéissent les différentes mesures entachées d’erreurs d’une même grandeur. Ces erreurs sont provoquées par un très grand nombre de causes d’une importance et d’un comportement analogues, indépendantes les unes des autres. Ce raisonnement justifie la phrase attribuée à Lippmann: «Les expérimentateurs considèrent cette loi comme un résultat théorique et les théoriciens comme un fait expérimental.»La loi de Poisson peut, elle aussi, être tenue pour une loi limite. Soit n variables indépendantes de Bernoulli ayant toutes la même loi (0 avec la probabilité qn et 1 avec la probabilité pn = 1 漣 qn ). La somme de ces n variables est le nombre de succès en n épreuves; sa fonction caractéristique est: si pn tend vers 0, de telle sorte que npn tende vers, cette fonction caractéristique tend vers:

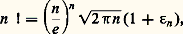

si pn tend vers 0, de telle sorte que npn tende vers, cette fonction caractéristique tend vers: fonction caractéristique de la loi de Poisson (cf. supra ). Dans la pratique, on utilise ce résultat de la manière suivante: Sur un grand nombre n d’épreuves indépendantes avec une faible probabilité p de succès à chaque épreuve, le nombre de succès dans ces n épreuves est une variable obéissant à une loi très voisine de celle de Poisson, avec = np .Signalons maintenant une généralisation de la loi des grands nombres donnée au début de ce chapitre (et concernant la convergence presque complètement sûre). Considérons n résultats aléatoires indépendants obéissant à une même loi de probabilité F(x ). Appelons Hn (x ) la fonction en escalier égale à la fréquence sur n résultats des résultats inférieurs à x . Cette fonction très utile en statistique est appelée histogramme de fréquence (fig. 2). Cantelli a établi que la suite des Hn (x ) converge presque complètement sûrement vers F(x ). La courbe en escalier y = Hn (x ) donne donc une idée d’autant plus précise de F(x ) que n est plus grand. Mentionnons aussi la loi du logarithme itéré , déjà citée (cf. chap. 6), due à Khintchine: Soit X1, X2, ..., Xn , ... des variables aléatoires indépendantes prenant la valeur 0 avec la probabilité q et 1 avec la probabilité p = 1 漣 q ; on a l’égalité:

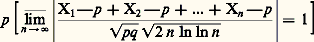

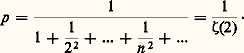

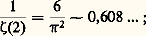

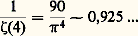

fonction caractéristique de la loi de Poisson (cf. supra ). Dans la pratique, on utilise ce résultat de la manière suivante: Sur un grand nombre n d’épreuves indépendantes avec une faible probabilité p de succès à chaque épreuve, le nombre de succès dans ces n épreuves est une variable obéissant à une loi très voisine de celle de Poisson, avec = np .Signalons maintenant une généralisation de la loi des grands nombres donnée au début de ce chapitre (et concernant la convergence presque complètement sûre). Considérons n résultats aléatoires indépendants obéissant à une même loi de probabilité F(x ). Appelons Hn (x ) la fonction en escalier égale à la fréquence sur n résultats des résultats inférieurs à x . Cette fonction très utile en statistique est appelée histogramme de fréquence (fig. 2). Cantelli a établi que la suite des Hn (x ) converge presque complètement sûrement vers F(x ). La courbe en escalier y = Hn (x ) donne donc une idée d’autant plus précise de F(x ) que n est plus grand. Mentionnons aussi la loi du logarithme itéré , déjà citée (cf. chap. 6), due à Khintchine: Soit X1, X2, ..., Xn , ... des variables aléatoires indépendantes prenant la valeur 0 avec la probabilité q et 1 avec la probabilité p = 1 漣 q ; on a l’égalité: Ce théorème nécessite, pour être établi, une étude très fine de la manière dont:

Ce théorème nécessite, pour être établi, une étude très fine de la manière dont: tend vers 1 et dont la loi de:

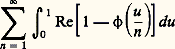

tend vers 1 et dont la loi de: tend vers sa limite.On doit à Paul Levy un beau théorème sur la convergence des séries aléatoires, qu’il a établi en utilisant la fonction de concentration qui lui est due (cf. chap. 3). Soit X1, X2, ..., Xn , ... une suite infinie de variables aléatoires indépendantes et Sn = X1 + ... + Xn la somme des n premières. Il suffit que Sn converge en loi vers une variable S pour que Sn converge presque sûrement (et par conséquent aussi en probabilité) vers S. Paul Levy a établi ce résultat pour des variables unidimensionnelles et J. Geffroy l’a généralisé à Rn . Kolmogorov a dégagé une condition de convergence des séries de variables indépendantes connue sous le nom de théorème des trois séries : Pour que Xn converge (en loi, en probabilité, ou presque sûrement, puisque nous venons de voir que les trois modes sont équivalents), il est nécessaire et suffisant qu’il existe M 礪 0 tel que, si l’on pose X n = Xn si | Xn | 諒 M et 0 si | Xn | 礪 M, les trois séries:

tend vers sa limite.On doit à Paul Levy un beau théorème sur la convergence des séries aléatoires, qu’il a établi en utilisant la fonction de concentration qui lui est due (cf. chap. 3). Soit X1, X2, ..., Xn , ... une suite infinie de variables aléatoires indépendantes et Sn = X1 + ... + Xn la somme des n premières. Il suffit que Sn converge en loi vers une variable S pour que Sn converge presque sûrement (et par conséquent aussi en probabilité) vers S. Paul Levy a établi ce résultat pour des variables unidimensionnelles et J. Geffroy l’a généralisé à Rn . Kolmogorov a dégagé une condition de convergence des séries de variables indépendantes connue sous le nom de théorème des trois séries : Pour que Xn converge (en loi, en probabilité, ou presque sûrement, puisque nous venons de voir que les trois modes sont équivalents), il est nécessaire et suffisant qu’il existe M 礪 0 tel que, si l’on pose X n = Xn si | Xn | 諒 M et 0 si | Xn | 礪 M, les trois séries: Dans cet énoncé s’introduit la notion de variable tronquée au niveau M. C’est un instrument de travail très utile en calcul des probabilités.On a également étudié le comportement des valeurs extrêmes d’un échantillon. Appelons mn et Mn respectivement la plus petite et la plus grande valeur d’un échantillon; on a les résultats suivants que l’on peut rapprocher des lois des grands nombres. Pour que Mn /n et mn /n convergent vers 0 en probabilité, il est nécessaire et suffisant que:

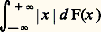

Dans cet énoncé s’introduit la notion de variable tronquée au niveau M. C’est un instrument de travail très utile en calcul des probabilités.On a également étudié le comportement des valeurs extrêmes d’un échantillon. Appelons mn et Mn respectivement la plus petite et la plus grande valeur d’un échantillon; on a les résultats suivants que l’on peut rapprocher des lois des grands nombres. Pour que Mn /n et mn /n convergent vers 0 en probabilité, il est nécessaire et suffisant que: pour que Mn /n et mn /n convergent presque sûrement vers 0, il est nécessaire et suffisant que l’intégrale:

pour que Mn /n et mn /n convergent presque sûrement vers 0, il est nécessaire et suffisant que l’intégrale: soit convergente; pour que Mn /n et mn /n convergent presque complètement sûrement vers 0, il est nécessaire et suffisant que:

soit convergente; pour que Mn /n et mn /n convergent presque complètement sûrement vers 0, il est nécessaire et suffisant que: soit convergente.9. Certaines lois de probabilitésLois sur les histogrammesDans le chapitre précédent, nous avons introduit la notion d’histogramme de fréquence et nous avons vu qu’il y a une probabilité égale à 1 pour que la suite des Hn (x ) converge presque complètement sûrement vers F(x ). Quand F(x ) est continue, on peut donner sur cette convergence des précisions supplémentaires. On peut mesurer l’écart de Hn (x ) à F(x ) de bien des façons. Deux d’entre elles se prêtent très aisément aux calculs aboutissant à la loi de probabilité ou à la fonction caractéristique; on peut retenir les formules suivantes:

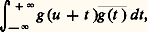

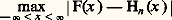

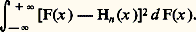

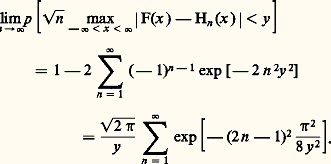

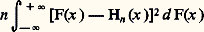

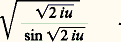

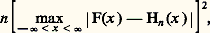

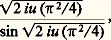

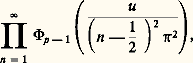

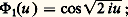

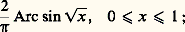

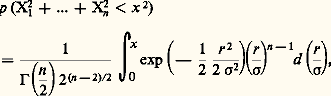

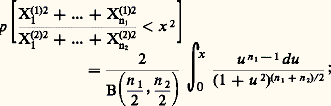

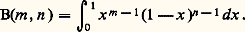

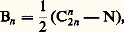

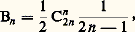

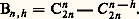

soit convergente.9. Certaines lois de probabilitésLois sur les histogrammesDans le chapitre précédent, nous avons introduit la notion d’histogramme de fréquence et nous avons vu qu’il y a une probabilité égale à 1 pour que la suite des Hn (x ) converge presque complètement sûrement vers F(x ). Quand F(x ) est continue, on peut donner sur cette convergence des précisions supplémentaires. On peut mesurer l’écart de Hn (x ) à F(x ) de bien des façons. Deux d’entre elles se prêtent très aisément aux calculs aboutissant à la loi de probabilité ou à la fonction caractéristique; on peut retenir les formules suivantes: et:

et: